3月13日、欧州議会がAI規則を可決しました。同議会が採択した法案が公開されていますので(Texts adopted - Artificial Intelligence Act - Wednesday, 13 March 2024)、それに基づいて、AI規則の概要を説明します。なお、本記事では、事業者の義務に関係する箇所に絞り、かつ、例外や細目的・手続的事項をかなり省略した説明を行いますので、ご留意ください。

概要

- 本規則の目的は、人間中心の信頼できる(human-centric and trustworthy)AIの導入を促進し、AIシステムの弊害から健康、安全、民主主義、法の支配、環境保護等のEU基本権憲章が定める基本権を保護し、イノベーションを支援することである。

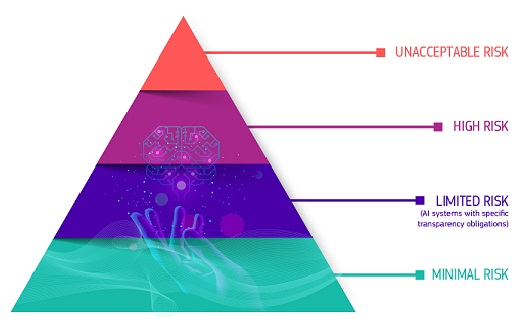

- 本規則は、①特定のAIの使用方法の禁止(Prohibited AI Practices. 2章)、②ハイリスクAIの規制(3章)、③特定のAIシステムに関する透明性義務(4章)、④汎用AIモデルの規制(5章)を定める。

- ①特定のAIの使用方法の禁止は、許容できないリスクを有すると考えられた9種類のAIの提供、使用を具体的に列挙し、これらを禁止するものである。

- ②ハイリスクAIの規制は、AIの使用目的に基づいてハイリスクなAIを定義し、7種類の要求事項を定め、これを担保するため、提供者(Provider)を中心に、導入者(Deployer. 欧州委員会案ではUserと命名されていた)、輸入者(Exporter)、販売者(Distributor)に各種の義務を課すものである。

- ③特定のAIシステムに関する透明性義務は、5種類のAIについて、提供者又は導入者に、AIを使用していることが分かるようにする措置を求めるものである。

- ④汎用AIモデルの規制は、汎用AI全般の提供者に4種類の義務を課すとともに、システミックリスクを有する汎用AIの提供者にさらに4種類の義務を課すものである。この規制は欧州議会・理事会により追加されたものであり、②が対象とするAIとはリスクの性質が異なるため(汎用AIは文字通り使用目的がない)、別枠で規制される。

- ①の違反は前年度全世界売上高の7%、②③④の違反は前年度全世界売上高の3%の制裁金の対象となる。①②③は加盟国が、④は欧州委員会が執行する。

なお、欧州委員会はかねてから以下の図を使用しており、オレンジが①、パープルが②、バイオレットが③、ターコイズが規制対象外のAIを表しているが、②の規制と③の規制は相互に排他的なものではなく、それぞれの要件に該当する限り両方の規制が適用されることに留意する必要がある(④もパープルに位置付けられると思われるところ、同様に③の規制と両立する)。

規制対象者の種類と適用範囲

- 本規則の主たる規制対象者は、提供者、導入者、輸入者、販売者である(3条(3)以下)。

- 本規則は、以下の者に適用される(2条1項)。

禁止されるAIの使用方法

本規則は、以下の9種類のAIの使用方法を禁止する(5条各号)。これらの禁止に対する違反は、加盟国による前年度全世界売上高の7%の制裁金の対象となる(99条3項)。

- サブリミナル技法等による行動の歪曲

- ①人の意識を超えたサブリミナル技法又は操作的若しくは欺瞞的な技法を使用し、人の意思決定を著しく損なうことにより、②その人又は集団の行動を実質的に歪曲し、③それにより、その人、他者又は集団に重大な損害を与え又はそのおそれがあるAIシステムの提供又は使用。

- 社会的・経済的状況による脆弱性の利用による行動の歪曲

- ①人の社会的・経済的状況による脆弱性を利用し、②その人又は集団の行動を実質的に歪曲し、③それにより、その人、他者又は集団に重大な損害を与え又はそのおそれがあるAIシステムの提供又は使用。

- 社会的スコアリング

- ①人の特定時点における社会的行動又は(知られた、推測された若しくは予測された)パーソナリティに基づいて、②人を社会的底あをもって評価又は格付けし、③それにより、(a)データが生成又は収集されたのとは関連しない文脈おける不利益に取扱い又は(b)正当化されない若しくは当該社会的行動に釣り合わない不利益取扱いをするAIシステムの提供又は使用。

- 犯罪リスクの評価・予測

- ①専らプロファイリング又は人の性格や特徴のアセスメントに基づき、②その人が犯罪行為に出るかどうかを予測するための、③リスクアセスメントを行うAIシステムの提供又は使用。

- 無差別スクレイピングによる顔認識データベースの作成等

- ①インターネット又は監視カメラから顔画像を無差別にスクレイピングし、②顔認識データベースを作成し又は拡張するAIシステムの提供又は使用。

- 職場・教育機関における感情推測

- ①職場又は教育機関において、②人の感情を推測するAIシステムの提供又は使用。ただし、③医療又は安全のための利用を除く。

- センシティブ事項を推測して行う生体分類

- 法執行目的でのリアルタイム遠隔生体識別

- ①公共空間における、②法執行目的での、③リアルタイム遠隔生体識別システムの使用。ただし、④(a)特定の誘拐、人身売買、性的搾取の被害者又は行方不明者の捜索、(b)一定の人の生命若しくは物理的安全に対する具体的、実質的かつ切迫した脅威又は明白かつ現在の又は明白かつ予測可能なテロの防止、(c)テロ、人身売買、児童の性的搾取・児童ポルノ、麻薬・向精神薬の違法取引、武器等の違法取引、殺人・重大な傷害、臓器等の違法取引、誘拐等の被疑者の居場所の特定又は識別のために行う場合を除く。

- 例外に基づきリアルタイム遠隔生体識別システムを使用する際は、①利益衡量を行い、②適切な保護措置及び条件に従い、基本権影響評価を経て、EUデータベースへの登録を行い、③緊急の場合を除き司法当局又は独立行政機関が事前の許可を得、④市場監視当局及びデータ保護当局に通知した場合にのみ行うことができる(5条2項以下)。

ハイリスクAIの規制

ハイリスクAI該当性

AIシステムは、以下の2つの場合にハイリスクAIとみなされる(6条1項)。

- ①当該AIシステムが別表1のEU法令に定める製品の安全コンポーネント又は当該製品それ自体であり、それらのEU法令に基づき第三者認証を受ける必要がある場合。

- 別表1のEU法令に定める製品とは、機械、玩具、娯楽用船舶、リフト、爆発性雰囲気下で使用される設備、無線機器、圧力設備、索道設備、個人防護具、ガス製品、医療機器、体外診断用医療機器、航空、自動車、農林用車両、船舶設備、鉄道等である。

- ②別表3に記載された以下のAIシステムである場合。なお、欧州委員会には、この別表3を修正する権限が与えられる(7条)。

- 生体関連技術:①遠隔生体識別システム(専らある自然人がその主張するとおりの人であることを確認するための生体検証システムを除く)、②センシティブ又は保護された属性又は特徴の推測に基づき生体分類を行うことを目的とするAIシステム、③感情認識を目的とするAIシステム

- 重要インフラ:重要なデジタルインフラ、道路交通又は水・ガス・暖房・電気の供給・管理・運用において安全コンポーネントとして使用することを目的とするAIシステム

- 教育・職業訓練:①教育機関・職業訓練機関へのアクセス、受入れ、割当てを決定するためのAIシステム、②学習成果を評価することを目的とするAIシステム、③教育機関・職業訓練機関において個人が受け又は受けることができる教育レベルの評価を目的とするAIシステム、④試験中の不正行為を監視・検知することを目的とするAIシステム

- 雇用・従業者管理・自営業へのアクセス:①自然人の採用・選抜を目的とするAIシステム、②(i)雇用条件等に影響する決定、昇格、雇用契約関係の終了に関する決定、(ii)個人の行動又は個人的特性若しくは特徴に基づく業務の割当て、(iii)雇用等の関係における個人のパフォーマンスと行動の監視・評価を目的とするAIシステム

- 重要な民間サービス・公共サービスの利用:①公的機関等による重要な公的給付・公共サービスの受給資格の評価を目的とするAIシステム、②自然人の信用力を評価することを目的とするAIシステム(詐欺を検知するためのものを除く)、③生命保険・健康保険における自然人のリスク評価・価格設定を目的とするAIシステム、④緊急通報の評価・分類を目的とするAIシステム

- 法執行:①法執行機関等による自然人が犯罪被害者となるリスクの評価を目的とするAIシステム、②法執行機関等によるポリグラフ等としての使用を目的とするAIシステム、③法執行機関等による証拠の信用性の評価を目的とするAIシステム、④法執行機関等による再犯可能性を評価するためのAIシステム、⑤法執行機関等によるプロファイリングに使用されるAIシステム

- 移民・亡命・国境管理:①公的機関によるポリグラフ等としての使用を目的とするAIシステム、②公的機関等による特定の自然人の入国によるリスクの評価を目的とするAIシステム、③公的機関等による亡命申請の審査を目的とするAIシステム、④公的機関等による移民、亡命、国境管理における自然人の検知・認識・識別を目的とするAIシステム(渡航文書の検証を除く)

- 司法・民主主義過程:①司法当局等による事実・法律の調査・解釈、法律の適用を目的とするAIシステム、②選挙・住民投票の結果又は自然人の投票行動に影響を与えることを目的とするAIシステム

ハイリスクAIの要求事項

ハイリスクAIには、以下の7種類の要求事項が課される。

- リスク管理体制(9条)

- 訓練、検証、テスト用データの品質(10条)

- 技術文書(11条)

- サービス提供前に技術文書が作成され、最新に保たれなければならない。

- 技術文書は、ハイリスクAIシステムが本規則の要求事項に準拠していることを証明し、準拠状況を評価するために必要な情報を明確かつ包括的に記載するものでなければならない。

- ロギング(12条)

- ハイリスクAIシステムは、運用期間中、自動的にイベントを記録(ロギング)するものでなければならない。

- ログは、①AIシステムが人々の健康、安全、基本的権利に対するリスク等を生じさせるおそれのある状況、②市販後モニタリングの促進、③導入者による監視活動に関連するイベントを含むものでなければならない。

- 導入者に対する透明性・情報提供(13条)

- ハイリスクAIシステムは、十分な透明性を備え、導入者がそのアウトプットを解釈し、適切に使用できるものでなければならない。

- 適切なデジタル形式の、アクセス可能で、理解しやすく、完結で、完全で、正確で、明確な情報を含む使用説明書を添付しなければならない。

- 使用説明書には、①提供者(及び代理人)の連絡先、②使用目的、③正確性、堅牢性、サイバーセキュリティのレベル、④想定される誤った使用方法、⑤「人間による監視」措置(導入によるAIシステムのアウトプットの解釈を容易にするために取った措置を含む)、⑥必要な計算・ハードウェア資源、ハイリスクAIシステムの予想寿命、必要なメンテナンス(アップデート等)の方法等を記載しなければならない。

- 人間による監視(14条)

- ハイリスクAIシステムは、人間が実効的な監視ができるよう、適切なヒューマンインターフェースを持たなければならない。

- 人間による監視は、使用目的に従って又は予想される誤った使用方法で使用された場合に生じうるリスクを防止又は最小化することを目的とし、提供者によってハイリスクAIに組み込まれる対策と、ユーザーが実施する対策の適切な組み合わせによってなされなければならない。

- 正確性、堅牢性、サイバーセキュリティ(15条)

- ハイリスクAIシステムは、適切なレベルの正確性、堅牢性、サイバーセキュリティを備えなければならない。

- これには、以下の事項が含まれる。①人間や他のシステムとの相互作用の結果生じる可能性のあるエラー等からの回復力、②バックアップ、フェイルセーフ計画等の冗長性確保、③フィードバックループの排除(サービス提供開始後も学習を続けるAIシステムの場合)、④脆弱性を利用した攻撃(データポイズニング、モデルポイズニング、敵対的サンプル等)に対する回復力。

ハイリスクAIに関係する事業者の義務

ハイリスクAIに関係する事業者には、主として以下の義務が課される。これらの義務に対する違反は、加盟国による前年度全世界売上高の3%の制裁金の対象となる(99条4項)。

- 提供者(16条~22条)

- 輸入者(23条)

- 販売者(24条)

- 導入者(26条)

- 使用説明書に沿ってハイリスクAIシステムを使用するよう技術的・組織的措置を取ること

- 必要な能力、訓練、権限、サポートを備えた者に「人間による監視」を行わせること

- インプットデータが使用目的に関連し、十分に代表的なものであることを確保すること

- 使用説明書に基づいてハイリスクAIシステムの動作を監視し、必要に応じて提供者に情報提供を行うこと

- 生成されたログの保管

- 基本権影響評価の実施(禁止規定の例外に基づき法執行目的でのリアルタイム遠隔生体識別を行う場合)(27条)

特定のAIシステムに関する透明性義務

透明性義務が課されるAIシステムの種類、義務者、義務の内容は以下のとおりである(50条)。これらの義務に対する違反は、加盟国による前年度全世界売上高の3%の制裁金の対象となる(99条4項)。

- 自然人と直接対話することを目的とするAIシステムの提供者は、AIシステムと対話していることが分かるようにすること。

- 音声、画像、ビデオ、テキストを生成・操作する汎用AIシステムを含むAIシステムの提供者は、AIシステムのアウトプットに機械可読なマーキングを行い、人工的に生成・操作されたものであることを検知できるようにすること。

- 感情認識システム、生体識別分類システムの導入者は、システムが動作していることを自然人に通知し、GDPR等に従って個人データを処理すること

- ディープフェイクを構成する画像、音声、ビデオを生成・操作するAIシステムの導入者は、コンテンツが人為的に生成・操作されたものであることを開示すること。

- 公共の利益に関する事項を公衆に知らせることを目的として公開されるテキストを生成・操作するAIシステムの導入者は、テキストが人為的に生成・操作されたものであることを開示すること(ただし、生成されたコンテンツが人間によるレビュー等を受けている場合を除く)。

汎用AIモデルの規制

システミックリスクを有する汎用AIモデル該当性

汎用AIモデルは、以下の場合にシステミックリスクを有する汎用AIモデルとみなされる(51条1項)。

- 適切な技術的ツールや方法に基づき、記録された最も先進的な(the most advanced)汎用AIモデルと同等又はこれを超える能力(高影響能力、high-impact capabilities。3条(65))を持つと評価される場合(この場合、当然に規制を受ける)。

- 欧州委員会が職権により、又は科学パネルの警告に従って、AIモデルが上記と同等の能力を持つと決定した場合。

なお、訓練に10の25乗(10Y=10ヨタ)FLOPS以上の計算能力が使用された汎用AIモデルは、高影響能力を持つと推定される(51条2項)。

汎用AIモデルの提供者の義務

汎用AIモデルの提供者には、以下の義務が課される。これらの義務に対する違反は、欧州委員会による前年度全世界売上高の3%の制裁金の対象となる(101条1項)。

- 全ての汎用AIモデルの提供者の義務(53条)

- システミックリスクを有する汎用AIモデルの提供者の義務(55条)

- システミックリスクの特定・軽減のためのモデル評価の実施

- システミックリスクの特定・軽減

- 重大インシデントとそれに対する対処に関する情報を収集し、文書化し、AI室等に報告すること

- システミックリスクを有する汎用AIモデルとその物理的インフラについて適切な水準のサイバーセキュリティを確保すること